BotNet

Por: Kevin Indig, que ha pasado 10 años como operador y líder en empresas de rápido crecimiento como Shopify, G2 y Atlassian. Desde mediados de 2022, ha sido asesor independiente de empresas emergentes de hipercrecimiento como Meta, Reddit, Ramp, Bounce, Snapchat, Dropbox, Toast y Nextdoor. Escribe Growth Memo, una newsletter para personas interesadas en la intersección entre marketing y estrategia empresarial.

¿Cómo cambia la web abierta el rápido crecimiento de los bots?

Más de la mitad del tráfico de la web proviene de bots:

El Informe sobre bots maliciosos de Imperva de 2024 revela que casi el 50 % del tráfico total de Internet no era humano en 2024. Tendencia: en declive. (1)

El Radar de Cloudflare muestra que alrededor del 70 % del tráfico es humano y el 30 % proviene de bots. (2)

Akamai informa de que el 42 % del tráfico en la web procede de bots. (3)

Hasta ahora, los bots han recopilado información que mejora las aplicaciones para los humanos. Pero una nueva especie crece en población: los bots agénticos. Durante dos décadas, optimizamos los sitios para GoogleBot. Pronto, podríamos centrarnos en ayudantes de IA que actúen como intermediarios entre los humanos y la web abierta.

Ya optimizamos para la BotNet con Schema y feeds de productos en el Merchant Center de Google. Los sitemaps XML se han convertido en una apuesta segura desde hace décadas. En el siguiente nivel, podríamos tener sitios web o API separados para bots con un campo de juego de marketing completamente nuevo.

Web con agentes

A medida que nos acercamos a tener más tráfico de bots que de humanos en la web abierta, es esencial tener en cuenta que se estima que alrededor del 65 % del tráfico de bots es malicioso. Los bots buenos incluyen scrapers de motores de búsqueda, herramientas de SEO, defensa de seguridad y, por supuesto, rastreadores de IA. Ambos tipos de bots están creciendo en población, pero solo los buenos son realmente útiles.

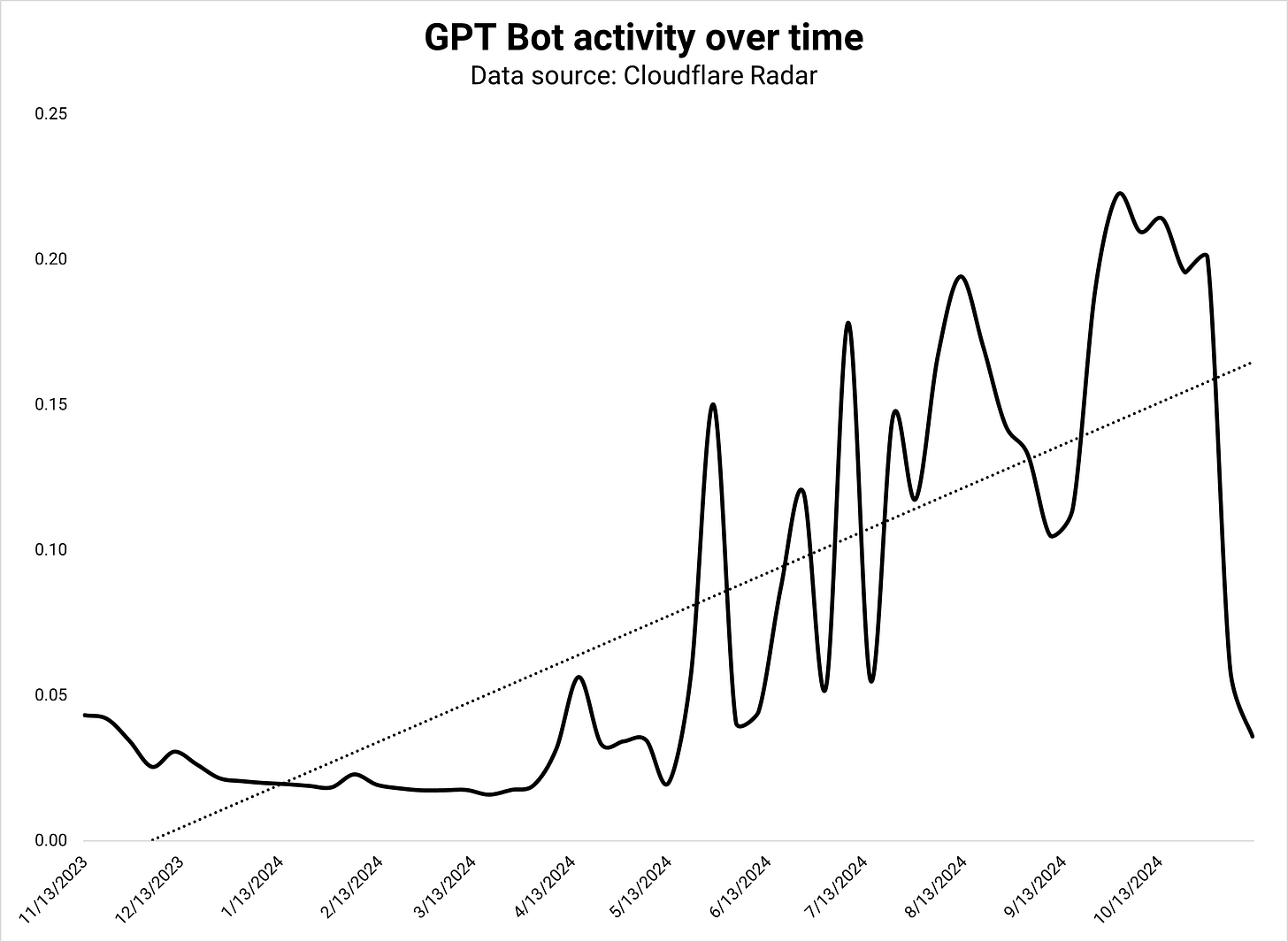

Comparando los últimos 6 meses con los anteriores, los rastreadores de IA crecieron un 18 %, mientras que los motores de búsqueda se ralentizaron un 10 %. GoogleBot redujo específicamente su actividad en un -1,6 %. Sin embargo, el rastreador de IA de Google lo compensó con un aumento del 1,4 %. El bot GPT fue el rastreador de IA más activo, con un 3,8 % de todas las solicitudes y un crecimiento del 12 %. El rastreador de IA de Google creció un 62 % y fue responsable del 3,7 % de todas las solicitudes de bots. Dada su tasa de crecimiento actual, el rastreador de IA de Google pronto debería ser el más activo de la web. (4)

Hoy en día, los bots de IA tienen tres objetivos:

Recopilar datos de entrenamiento

Crear un índice de búsqueda para fundamentar las respuestas de LLM (RAG)

Recopilar datos en tiempo real para avisos que exigen frescura.

Pero actualmente, todos los grandes desarrolladores de IA trabajan en agentes que navegan por la web y actúan en nombre de los usuarios:

Claude fue el primero con su función de producto «Uso del ordenador»: «Los desarrolladores pueden indicar a Claude que utilice los ordenadores como lo hace la gente: mirando una pantalla, moviendo un cursor, haciendo clic en botones y escribiendo texto». (5)

Jarvis de Google, «un compañero útil que navega por la web por ti», se lanzó accidentalmente en la tienda Chrome por un momento. (6)

OpenAI trabaja en «Operator», también un agente que actúa por ti. (7)

Veo tres resultados posibles:

Los agentes aumentan significativamente el tráfico de bots en la web abierta a medida que rastrean y visitan sitios web.

Los agentes utilizan API (interfaces de programación de aplicaciones) para obtener información.

Los agentes operan en su plataforma, lo que significa que el Operador utiliza únicamente datos de Chat GPT en lugar de recopilar los suyos propios.

Creo que lo más probable es una mezcla de las tres, con el resultado de que el tráfico de bots crecería significativamente. Si eso resulta ser cierto, las empresas crearán cada vez más versiones separadas de su sitio para bots orientadas a la velocidad y a los datos estructurados. «Céntrate solo en el usuario» se convierte en «céntrate solo en los agentes».

En cierto modo, Chat GPT Search ya es un agente que navega y selecciona la web para los humanos. Pero si los agentes cumplen su promesa, puedes esperar mucho más. El director ejecutivo de OpenAI, Sam Altman, en su reciente AMA en Reddit: «Creo que lo que se sentirá como el próximo gran avance serán los agentes».

Mientras los bots conquistan la web, ¿qué están haciendo los humanos?

Adopción de Internet

Es poco probable que los humanos dejen de navegar por la web por completo. Incluso con las respuestas de IA en las búsquedas y las funciones de búsqueda en los chatbots de IA, los humanos siguen queriendo verificar las afirmaciones de la IA, inspirarse al azar (serendipia) o buscar respuestas de otros humanos (Reddit). Pero el acto de navegar para buscar probablemente se disolverá en indicaciones si los bots se vuelven lo suficientemente buenos.

Hay margen de crecimiento en el tráfico humano: el 70 % de la población mundial tenía acceso a Internet en 2023. Al ritmo actual (~7 % interanual), el mundo entero tendría acceso a Internet en 2030. Sin embargo, a pesar de la creciente adopción de Internet, el tráfico humano se ha mantenido estable en los últimos 3 años (ver estadísticas de Cloudflare). Los rastreadores de IA crecen mucho más rápido (18 %), y los agentes podrían acelerarlo aún más.

Las solicitudes humanas a Wikipedia, el sitio más grande de la web, se han estancado desde 2019. (8)

La razón es que la atención humana se desplaza a las plataformas sociales, especialmente para las generaciones más jóvenes. A medida que los bots se apoderan de la web abierta, los humanos huyen a retiros de compromiso.

Marketing

En un futuro lejano, los buenos bots podrían convertirse en ciudadanos con los mismos derechos de la nación de la web abierta a medida que más humanos pasen tiempo en plataformas sociales cerradas y los LLM agenciales aumenten el ya rápido crecimiento del tráfico de bots. Si esta teoría se cumple, ¿qué significa esto para el marketing y, específicamente, para el SEO?

Imagina que reservas un viaje. En lugar de navegar por Google o Booking, le dices a tu agente adónde crees que irás y cuándo. Basándose en lo que sabe de tus preferencias, tu agente selecciona 3 opciones de vuelos y hoteles de la plataforma que elijas. Eliges un vuelo, se añade a tu calendario y los billetes están en tu bandeja de entrada. No necesitas pagar. El agente hace todo por ti. Podrías aplicar el mismo escenario al comercio electrónico o al software. Dado que empresas como Google ya tienen la capacidad de construir esto hoy en día, vale la pena pensar en lo que permanecería constante, lo que cambiaría y lo que se volvería más y menos importante en esta visión.

Constante

Los bots no necesitan CSS ni imágenes hero. No hay ningún inconveniente en ocultar tu sitio a los rastreadores LLM, por lo que existe la posibilidad de que los sitios web muestren a los bots una versión básica. Un conjunto de habilidades que permanece constante en este futuro es el SEO técnico: rastreabilidad, velocidad (del servidor), enlaces internos y datos estructurados.

Cambio

Una web abierta y con agentes ofrece capacidades de segmentación de anuncios mucho mejores, ya que los bots conocen a sus propietarios al dedillo. Los humanos tomarán decisiones de compra mucho más rápido, ya que sus agentes les proporcionan toda la información que necesitan y conocen sus preferencias. Los costes publicitarios disminuyen significativamente y ofrecen rendimientos aún mayores que en la actualidad.

Dado que los bots pueden traducir cualquier cosa en segundos, la localización y las ventas internacionales ya no son un problema. Los humanos pueden comprar a cualquiera, en cualquier lugar, con las únicas limitaciones del envío y el inventario. La economía global se abre aún más.

Si lo hacemos bien, los agentes podrían ser los guardianes definitivos de la privacidad: nadie tiene tantos datos sobre ti como ellos, pero tú puedes controlar cuántos comparten. Los agentes te conocen, pero no necesitan compartir esa información con otros. Podríamos compartir aún más datos con ellos, haciendo girar el volante de valor de datos → comprensión → resultados → datos → valor → resultados → etc.

En el lado negativo, necesitamos construir defensas contra bots maliciosos redefiniendo lo que los bots pueden hacer en un formato similar a robots.txt 2.0. La ciberseguridad se vuelve aún más importante, pero también más compleja, ya que los bots malos pueden imitar mucho mejor a los buenos.

Tendremos que averiguar el impacto medioambiental de un mayor consumo de energía debido a un mayor tráfico de bots. Con suerte, los bots son más eficientes y, por lo tanto, causan menos tráfico web total que los humanos. Esto compensaría al menos en parte el consumo energético que ya están causando los LLM.

Importante

El formato de información más apto para los bots es el formato sin procesar y estructurado: XML, RSS y fuentes API. Ya hemos enviado fuentes de productos y mapas de sitio XML a Google, pero los agentes querrán más. El diseño web será menos importante en el futuro, y tal vez eso esté bien, ya que la mayoría de los sitios se parecen mucho de todos modos. El diseño de las fuentes se vuelve más importante: qué información incluir en las fuentes, cuánta, con qué frecuencia actualizarla y qué solicitudes enviar a los bots.

Los especialistas en marketing dedicarán mucho más tiempo a hacer ingeniería inversa de cómo son las conversaciones con los chatbots. Es probable que los bots sean una caja negra como el algoritmo de Google, pero la publicidad podría arrojar luz sobre lo que más preguntan las personas.

Relaciones

En el futuro de los agentes, es difícil conseguir que los clientes cambien una vez que se han decidido por una marca que les gusta, a menos que tengan una mala experiencia. Como resultado, una palanca de marketing importante será conseguir que los clientes prueben tu marca con campañas como descuentos y ofertas exclusivas. Una vez que tengas convicción y señales de que tu producto es mejor, la búsqueda se convierte en persuadir a los usuarios para que lo prueben. Obviamente, eso ya funciona hoy en día. Con tantas oportunidades para anunciar y convencer a los usuarios de un producto específico de forma orgánica antes de que compren, tenemos mucha más influencia en la compra. Pero, en el futuro, los agentes podrían tomar esas decisiones por los usuarios. Los especialistas en marketing dedicarán más tiempo a la construcción de relaciones, a la creación de conciencia de marca y a influir en factores de marketing de la vieja escuela como los precios, la distribución (envío) y la diferenciación.

También puede interesar, de Kevin:

Notas:

1- https://www.imperva.com/resources/resource-library/reports/2024-bad-bot-report/

2- https://radar.cloudflare.com/?dateRange=52w

Qué obtienen los lectores de Growth Memo:

Marcos: cómo abordar las decisiones estratégicas sobre el crecimiento orgánico, por ejemplo, cómo evaluar el verdadero potencial comercial del SEO para diferentes tipos de empresas.

Modelos mentales: patrones y principios que Kevin ha reconocido en diferentes empresas y situaciones.

Herramientas de decisión: enfoques para tomar mejores decisiones estratégicas sobre el crecimiento orgánico, como la asignación de recursos, el tiempo o la evaluación de riesgos.

Datos: estadísticas, estudios de casos y números que explican y grafican las tendencias que los responsables de la toma de decisiones necesitan conocer.

Escenarios reales: escenarios anónimos del trabajo del asesor de Kevin para destacar el proceso de pensamiento estratégico y los marcos en acción.