SEOzempic

Por: Kevin Indig, que ha pasado 10 años como operador y líder en empresas de rápido crecimiento como Shopify, G2 y Atlassian. Desde mediados de 2022, ha sido asesor independiente de empresas emergentes de hipercrecimiento como Meta, Reddit, Ramp, Bounce, Snapchat, Dropbox, Toast y Nextdoor. Escribe Growth Memo, una newsletter para personas interesadas en la intersección entre marketing y estrategia empresarial.

Hay dos cosas que han cambiado cómo Google indexa. Mientras que la web abierta se ha reducido, Google tiene que rastrear grandes plataformas de contenido como YouTube, Reddit y TikTok, que a menudo están construidas con marcos JS «complejos», para encontrar contenido nuevo. Al mismo tiempo, la IA está cambiando la dinámica de la web al hacer que el contenido mediocre y de mala calidad sea innecesario.

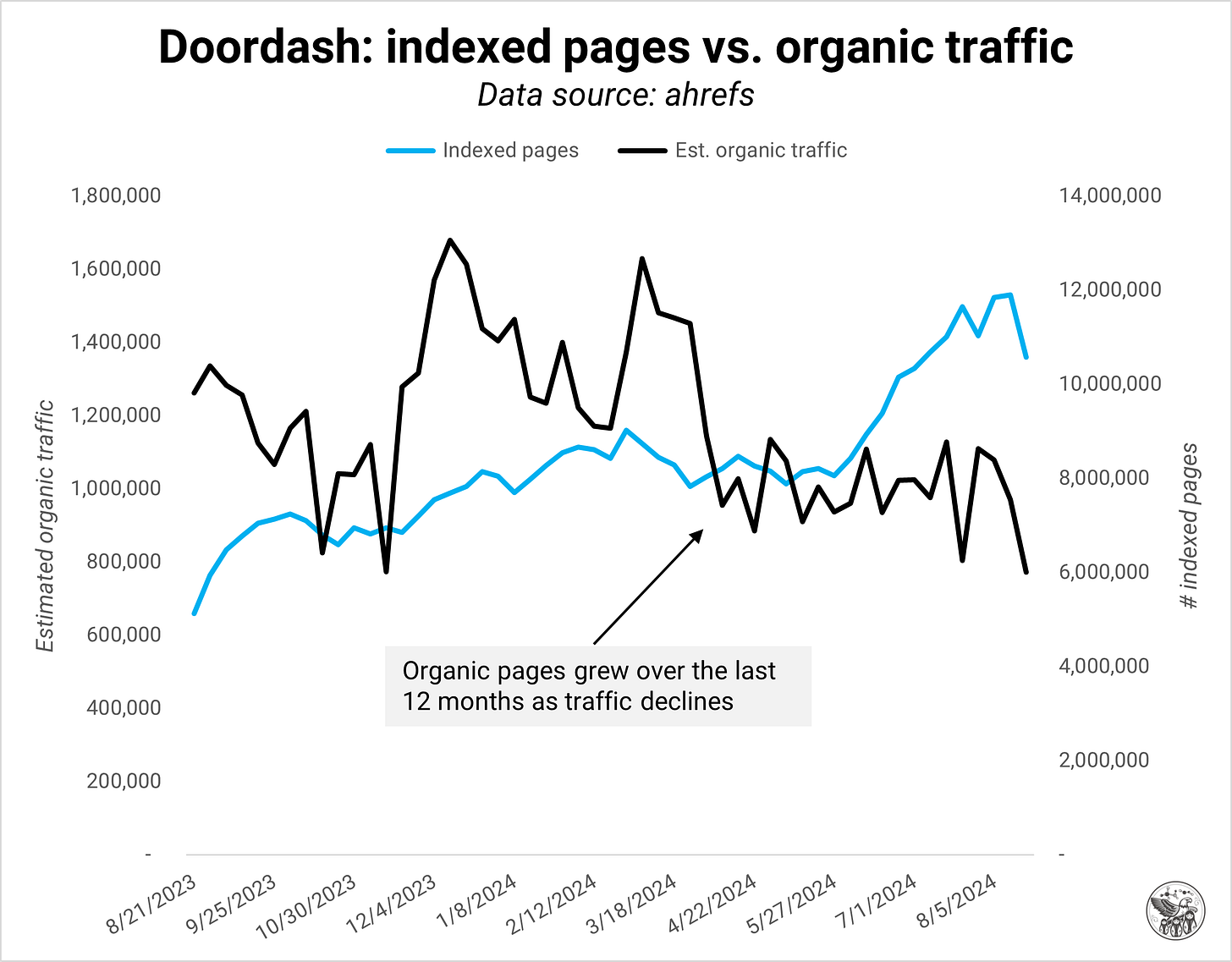

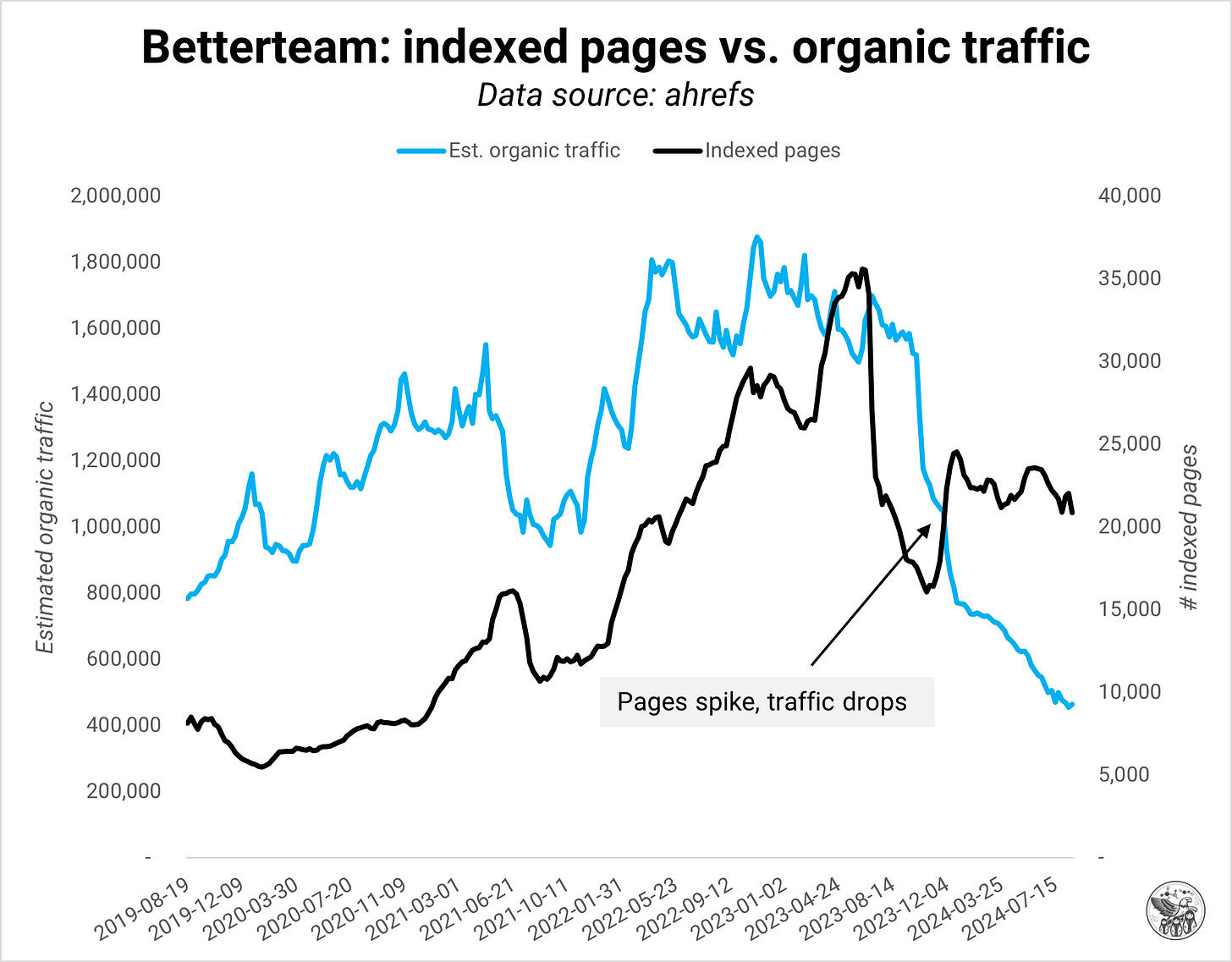

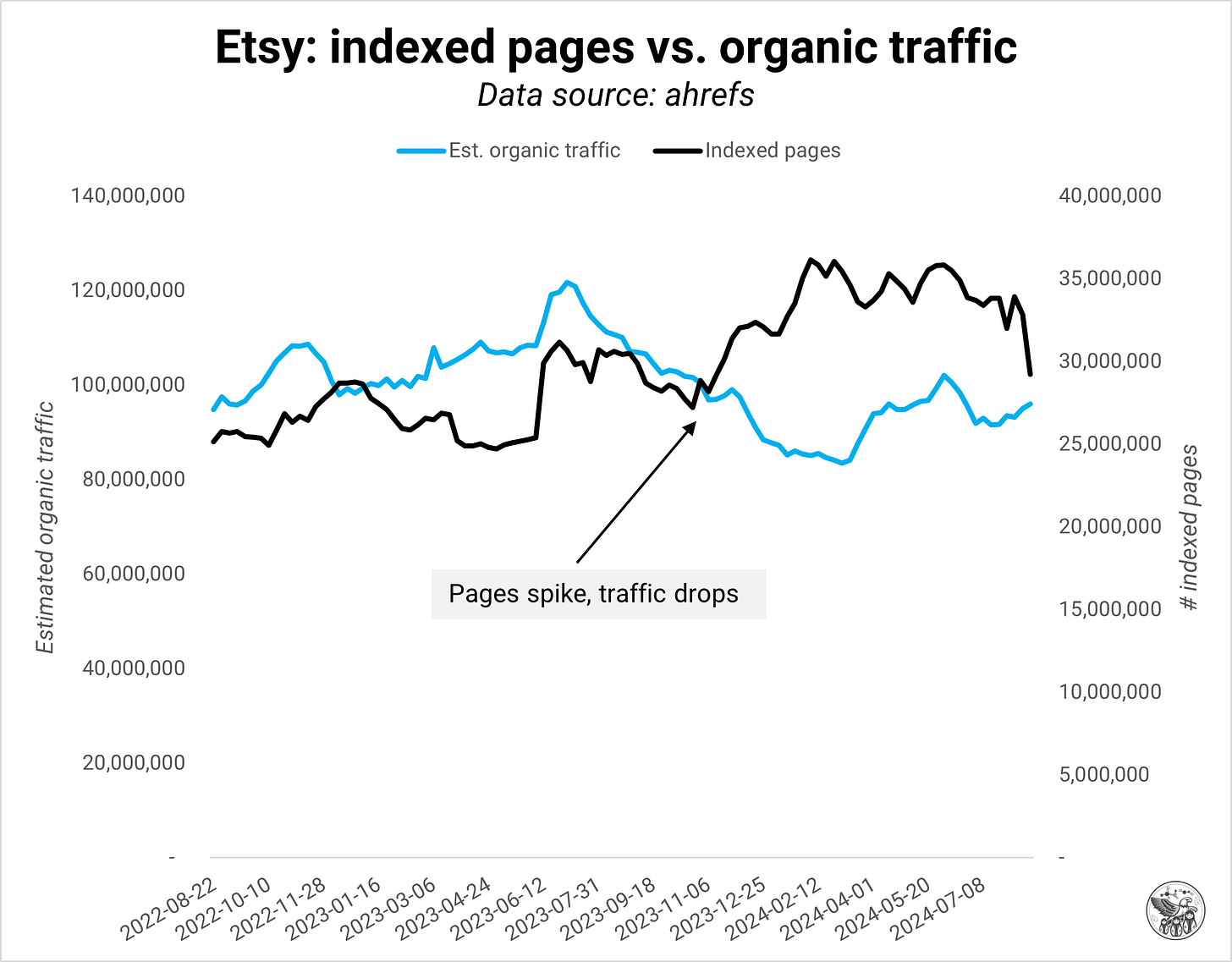

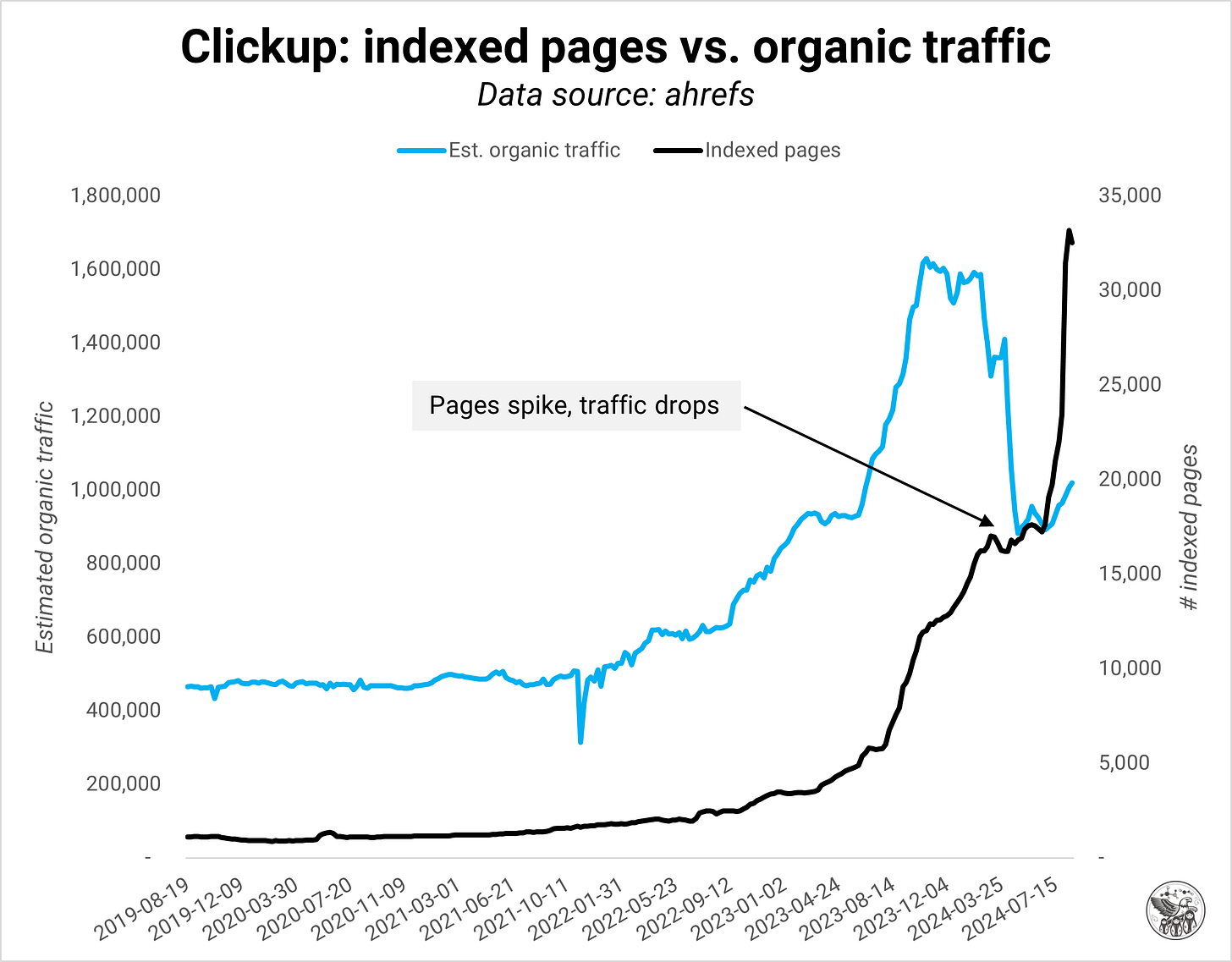

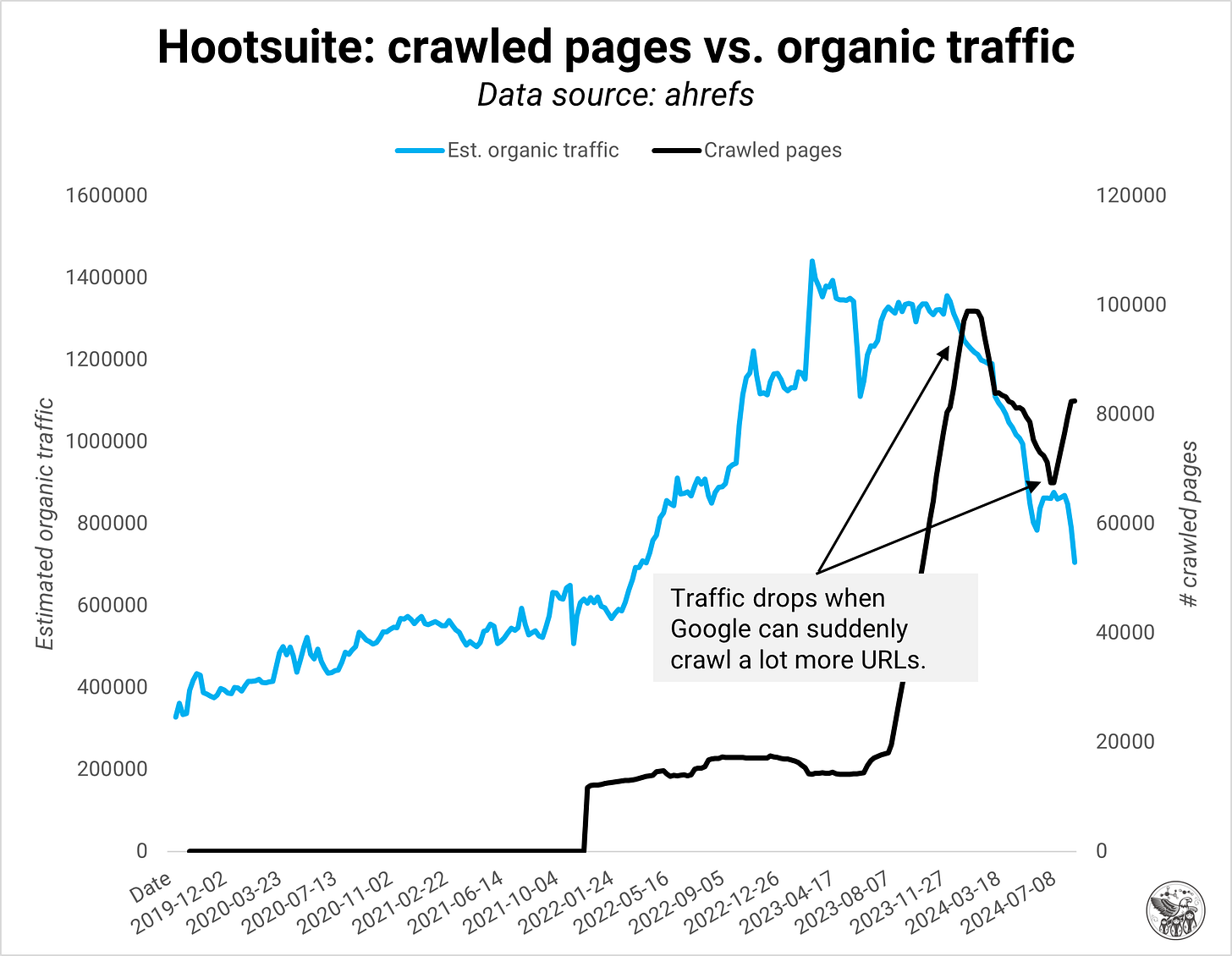

En mi trabajo con algunos de los sitios web más grandes, últimamente he notado una relación inversa entre las páginas indexadas y el tráfico orgánico. Tener más páginas no es automáticamente malo, pero a menudo no cumplen con las expectativas de calidad de Google. O, en mejores términos, la definición de calidad ha cambiado. Hay mucho en juego para los SEO: si te expandís demasiado, todo tu dominio podría sufrir. Tenemos que cambiar nuestra forma de pensar sobre la calidad y desarrollar sistemas de monitoreo que nos ayuden a entender la calidad del dominio a nivel de página.

Saciados

Google ha cambiado la forma en que trata los dominios, a partir de octubre de 2023: No había ejemplos que mostraran esta relación inversa antes de octubre. Además, Google tuvo problemas de indexación cuando lanzó la actualización del algoritmo Core de octubre de 2023, al igual que ha ocurrido ahora con la actualización de agosto de 2024.

Antes del cambio, Google indexaba todo y daba prioridad al contenido de mayor calidad de un dominio. Piensa en ello como si se tratara de buscar oro, en el que se llena una bandeja con grava, tierra y agua y luego se agita y se remueve hasta que solo queda el material valioso.

Ahora, un dominio y su contenido deben demostrar su valía antes de que Google siquiera intente buscar el oro. Si el dominio tiene demasiado contenido de baja calidad, Google podría indexar solo algunas páginas o, en casos extremos, ninguna.

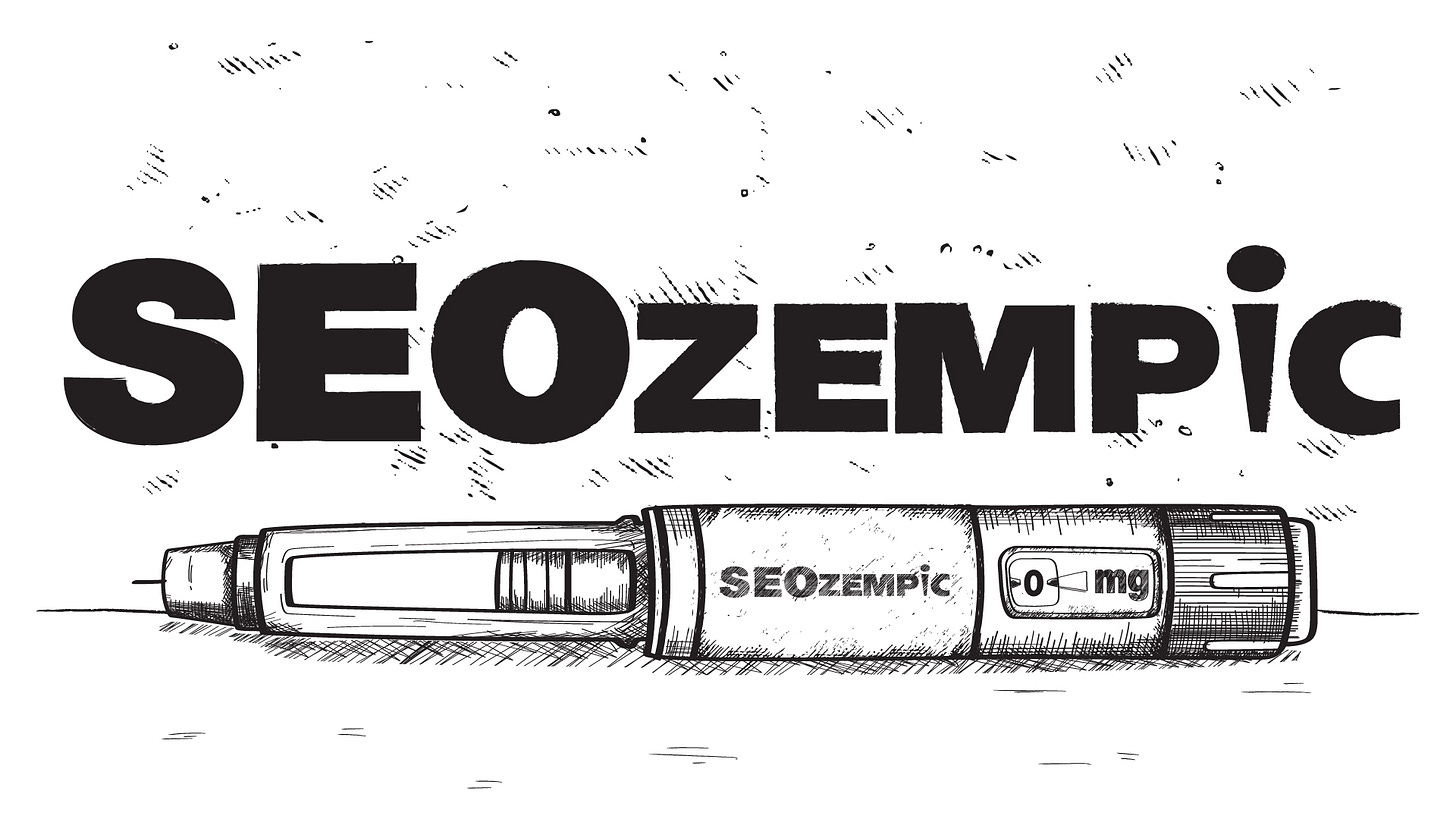

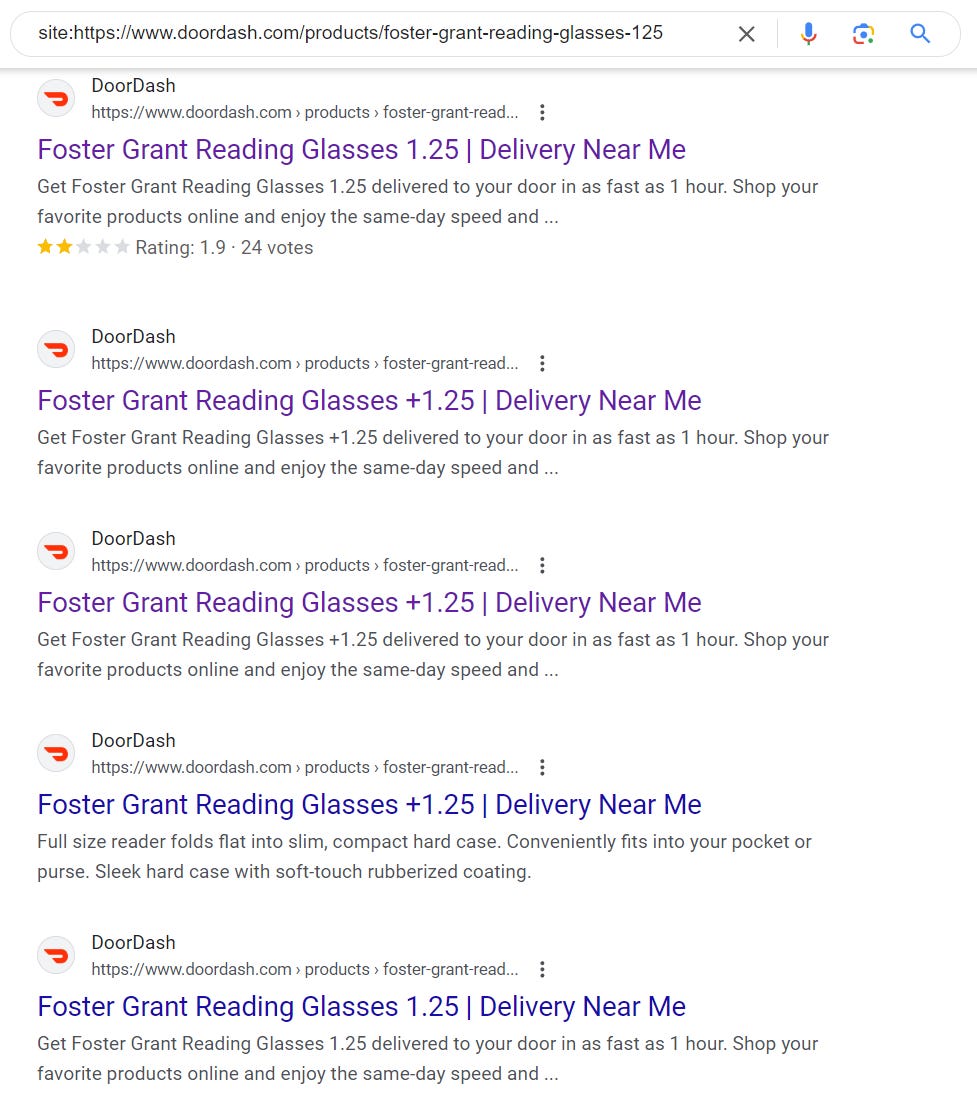

Un ejemplo es doordash.com, que ha añadido muchas páginas en los últimos 12 meses y ha perdido tráfico orgánico en el proceso. Al menos algunas, quizá todas, de las nuevas páginas no cumplían las expectativas de calidad de Google.

Pero, ¿por qué? ¿Qué ha cambiado? Mi razonamiento es el siguiente:

Google quiere ahorrar recursos y costes a medida que la empresa avanza hacia una mentalidad de eficiencia operativa.

La indexación parcial es más efectiva contra el contenido de baja calidad y el spam. En lugar de indexar y luego intentar clasificar las nuevas páginas de un dominio, Google observa la calidad general de un dominio y trata las nuevas páginas con el escepticismo correspondiente.

Si un dominio produce repetidamente contenido de baja calidad, no tiene la oportunidad de contaminar aún más el índice de Google.

El nivel de calidad de Google ha aumentado porque hay mucho más contenido en la web, pero también para optimizar su índice para RAG (grounding AI Overviews) y entrenar modelos.

Este énfasis en la calidad del dominio como señal significa que tenés que cambiar la forma de supervisar tu sitio web para tener en cuenta la calidad. Mi principio rector: «Si no podés añadir nada nuevo o mejor a la web, es probable que no sea lo suficientemente bueno».

Alimentación de calidad

La calidad del dominio es mi término para describir la proporción de páginas indexadas que cumplen con el estándar de calidad de Google frente a las que no. Ten en cuenta que solo las páginas indexadas cuentan para la calidad. El porcentaje máximo de páginas «malas» antes de que Google reduzca el tráfico a un dominio no está claro, pero sin duda podemos ver cuándo se alcanza:

También:

También:

Defino la calidad del dominio como una señal compuesta por tres áreas: experiencia del usuario, calidad del contenido y condición técnica:

Experiencia del usuario: ¿los usuarios encuentran lo que buscan?

Calidad del contenido: ganancia de información, diseño del contenido, exhaustividad

Optimización técnica: contenido duplicado, renderización, contenido en la página para el contexto, «rastreado, no indexado/descubierto», errores 404 suaves.

Un ejemplo de contenido duplicado

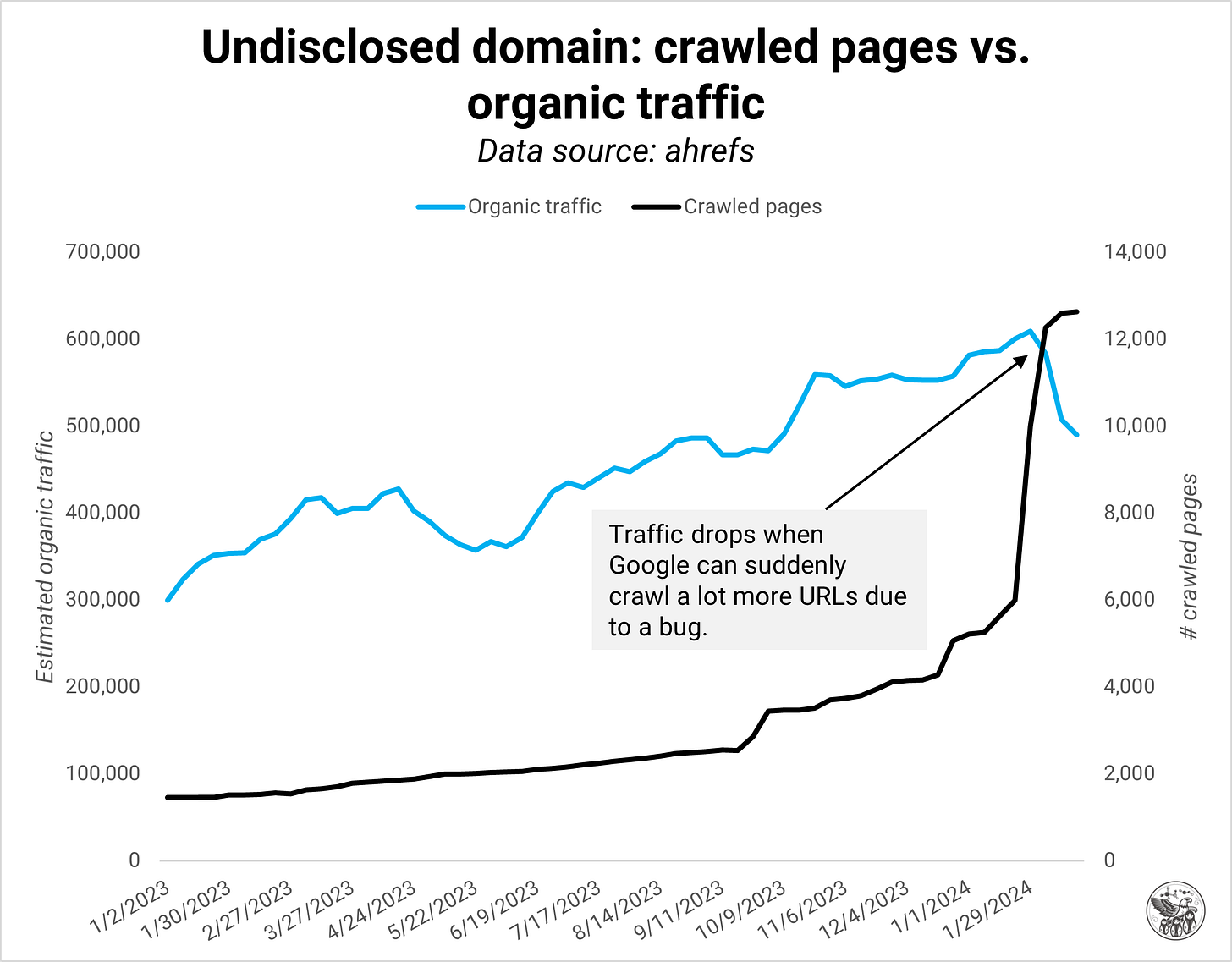

Un aumento repentino de las páginas indexadas suele indicar un problema técnico, como contenido duplicado de parámetros, internacionalización o paginaciones rotas. En el ejemplo siguiente, Google redujo inmediatamente el tráfico orgánico a este dominio cuando se rompió la lógica de paginación, lo que provocó mucho contenido duplicado. Nunca había visto a Google reaccionar tan rápido ante errores técnicos, pero esa es la nueva realidad del SEO.

En otros casos, un aumento en las páginas indexadas indica una estrategia de SEO programático en la que el dominio lanzó muchas páginas con la misma plantilla. Cuando la calidad del contenido de las páginas programáticas no es lo suficientemente buena, Google cierra rápidamente el grifo del tráfico.

También:

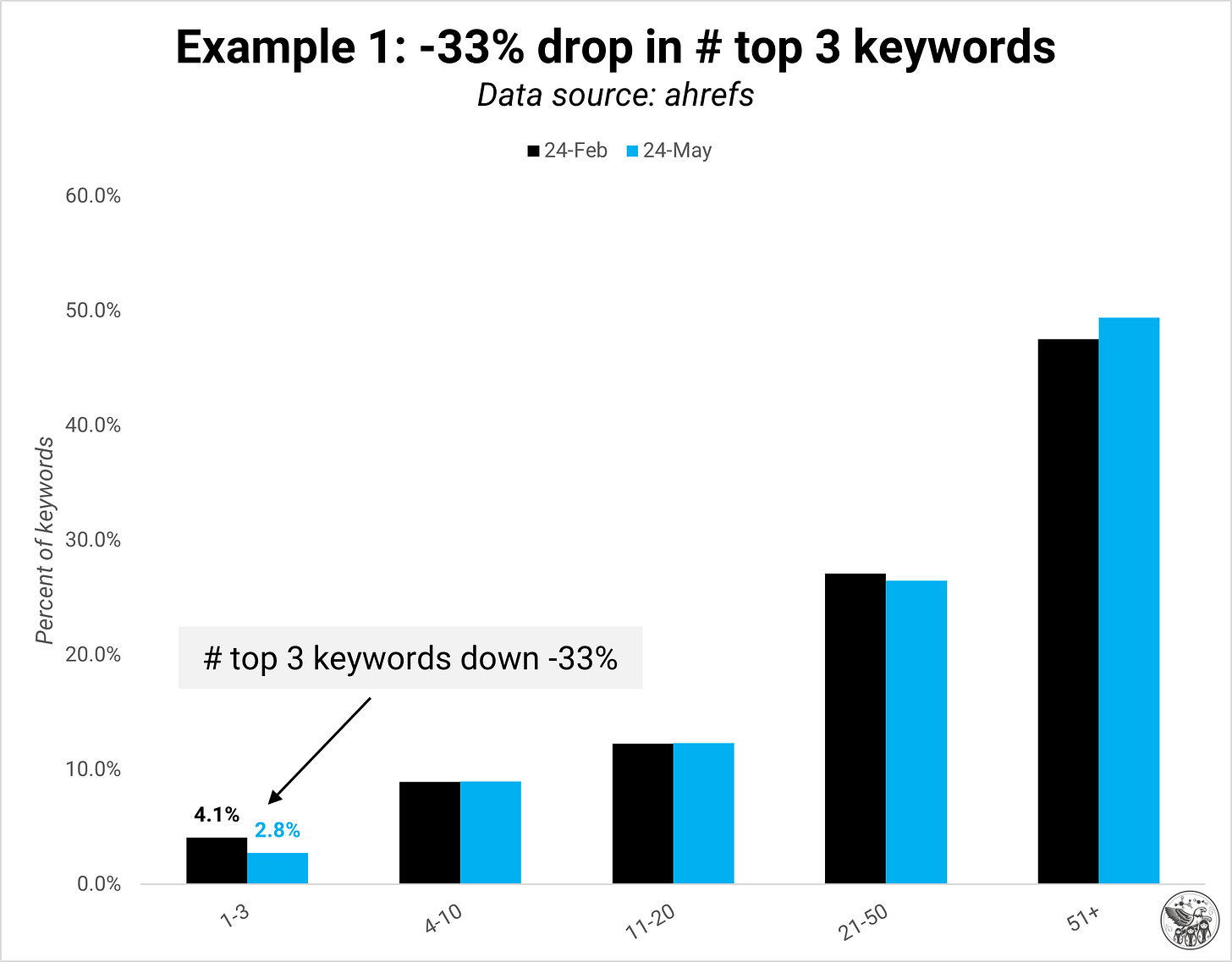

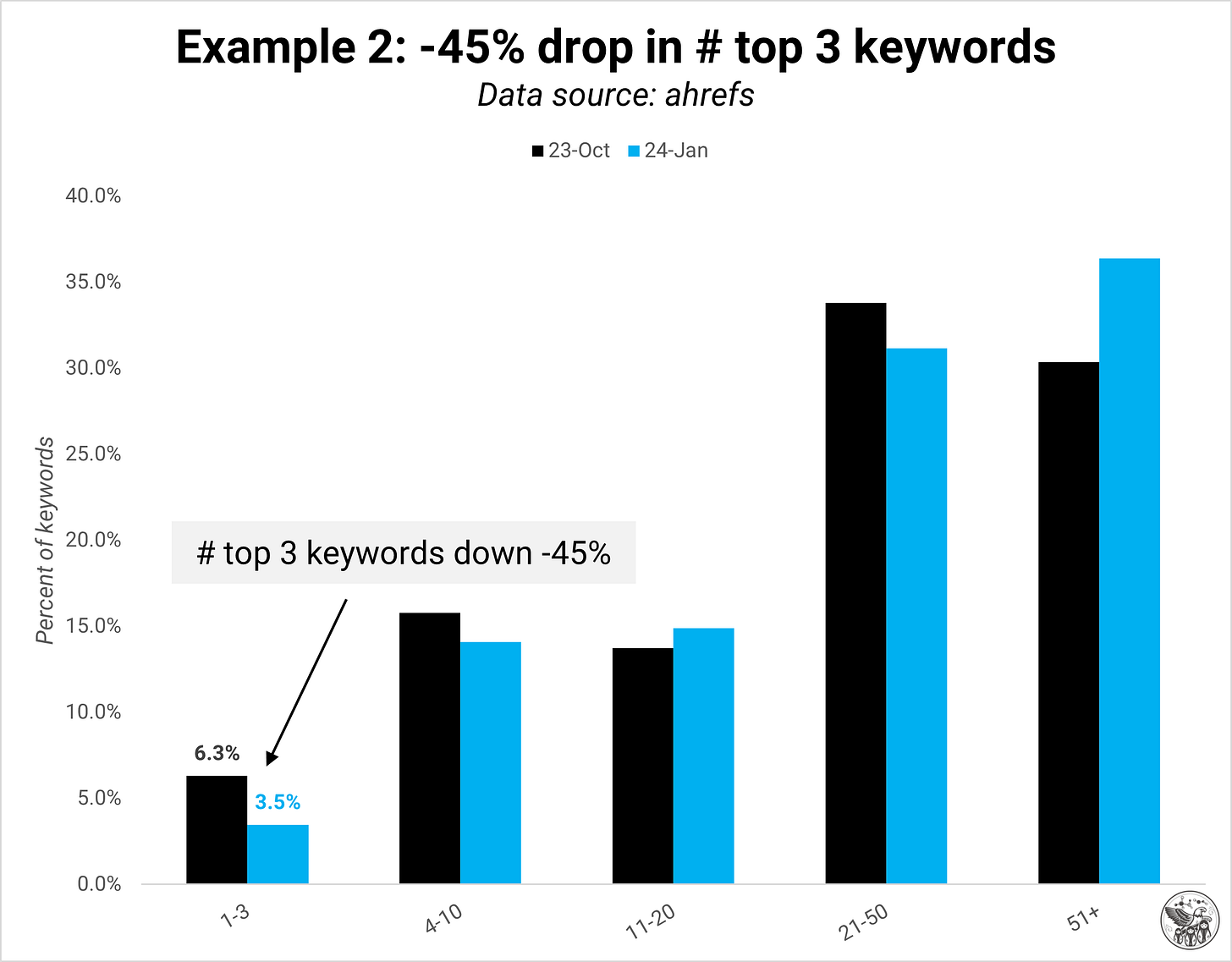

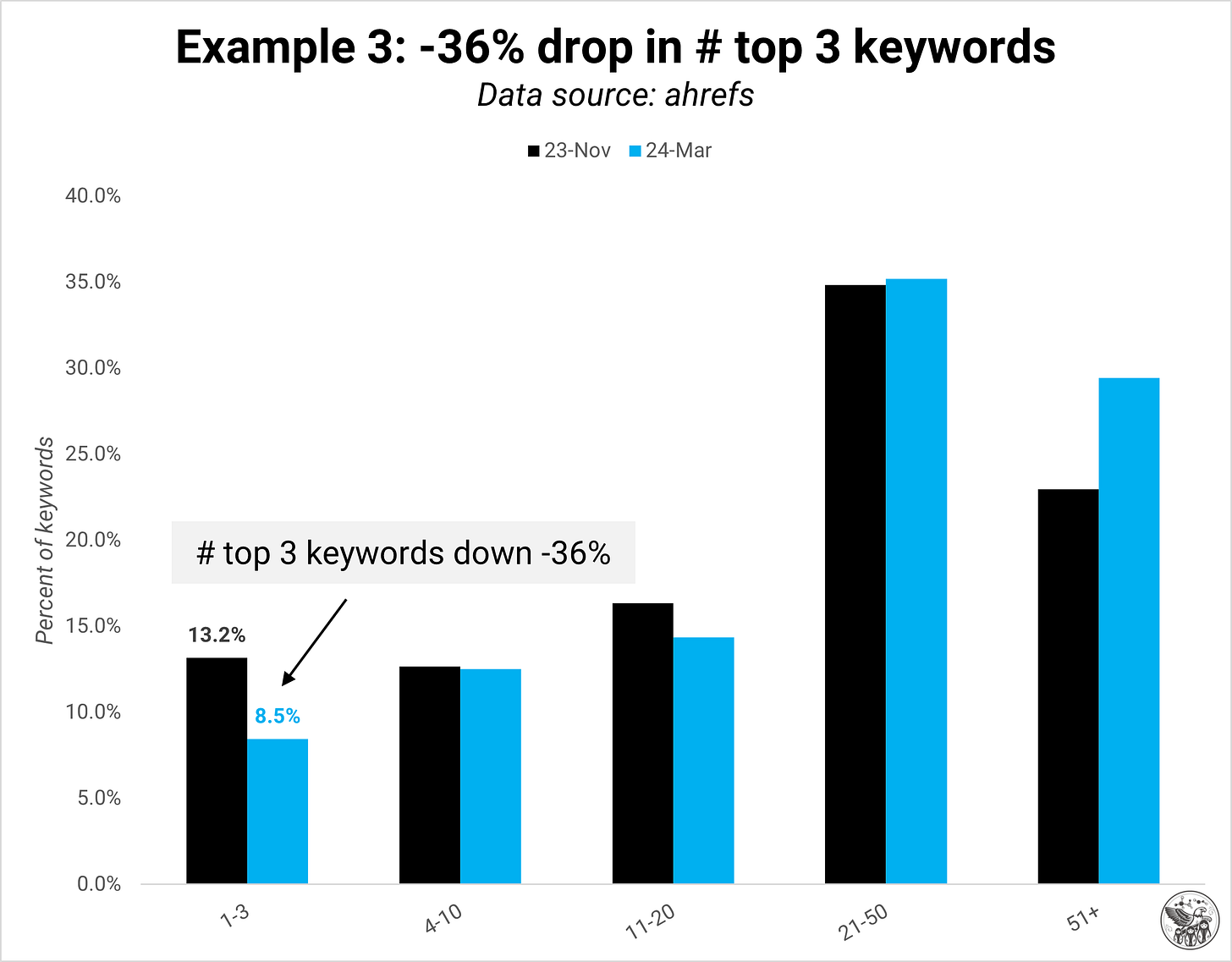

En respuesta, Google suele reducir el número de palabras clave que se posicionan en las tres primeras posiciones. El número de palabras clave que se posicionan en otras posiciones suele ser relativamente estable.

También:

Además:

El tamaño aumenta el problema: la calidad del dominio puede ser un problema mayor para los sitios web más grandes, aunque los más pequeños también pueden verse afectados.

Añadir nuevas páginas a tu dominio no es malo en sí mismo. Solo hay que tener cuidado. Por ejemplo, publicar nuevos contenidos de liderazgo intelectual o de marketing de productos que no estén directamente orientados a una palabra clave puede seguir siendo muy valioso para los visitantes del sitio web. Por eso es fundamental medir el compromiso y la satisfacción de los usuarios, además de las métricas de SEO.

Plan de dieta

La forma más importante de mantener a raya la «grasa» (páginas de baja calidad) y reducir el riesgo de que te afecte una actualización de Core es poner en marcha un buen sistema de monitorización. Es difícil mejorar lo que no se mide.

En el corazón de un sistema de monitorización de la calidad del dominio hay un panel de control que realiza un seguimiento de las métricas de cada página y las compara con la media. Si solo pudiera elegir tres métricas, mediría la tasa de rebote inversa, las conversiones (blandas y duras) y los clics + clasificaciones por tipo de página por página en comparación con la media. Lo ideal es que tu sistema te avise cuando se produzca un pico en la tasa de rastreo, especialmente en el caso de las páginas nuevas que no se han rastreado anteriormente.

Como escribo en Cómo miden la calidad del contenido las mejores empresas:

1/ Para la calidad de la producción, mide métricas como la puntuación del editor SEO, la puntuación de Flesch/legibilidad o el número de errores ortográficos/gramaticales.

2/ Para la calidad del rendimiento, mide métricas como el número de clasificaciones entre las tres primeras, la relación entre el tiempo de permanencia en la página y el tiempo de lectura estimado, la tasa de rebote inversa, la profundidad de desplazamiento o el valor del canal.

3/ Para la calidad de la conservación, mide las métricas de rendimiento a lo largo del tiempo y de un año a otro.

Ignora páginas como «Términos del servicio» o «Quiénes somos» cuando supervises tu sitio, ya que su función no tiene nada que ver con el SEO.

Fase de ganancia

La supervisión es el primer paso para entender la calidad del dominio de tu sitio. No siempre es necesario añadir más páginas para crecer. A menudo, puedes mejorar tu inventario de páginas existente, pero necesitas un sistema de supervisión para averiguarlo.

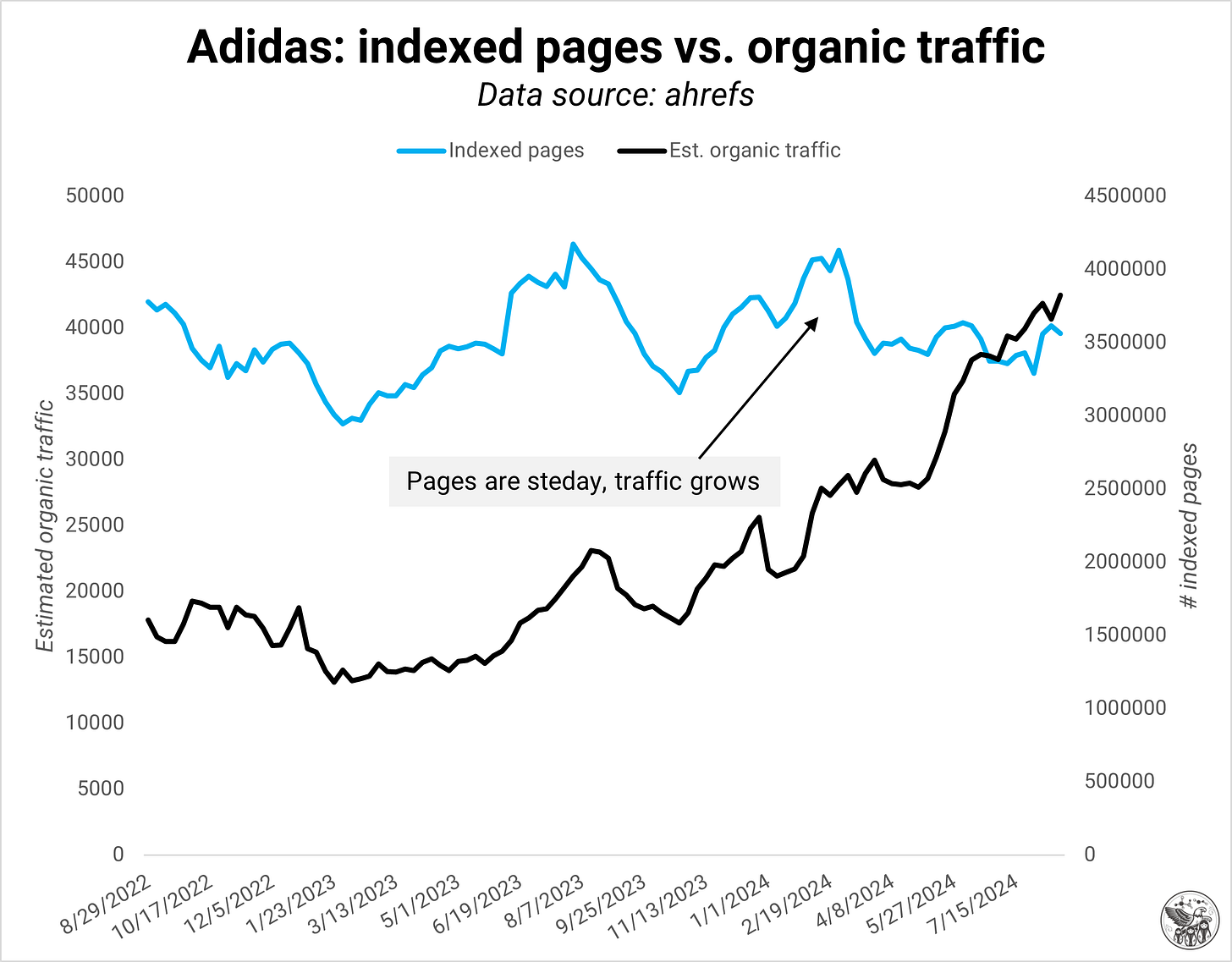

Adidas es un buen ejemplo de un dominio que logró aumentar el tráfico orgánico simplemente optimizando sus páginas existentes.

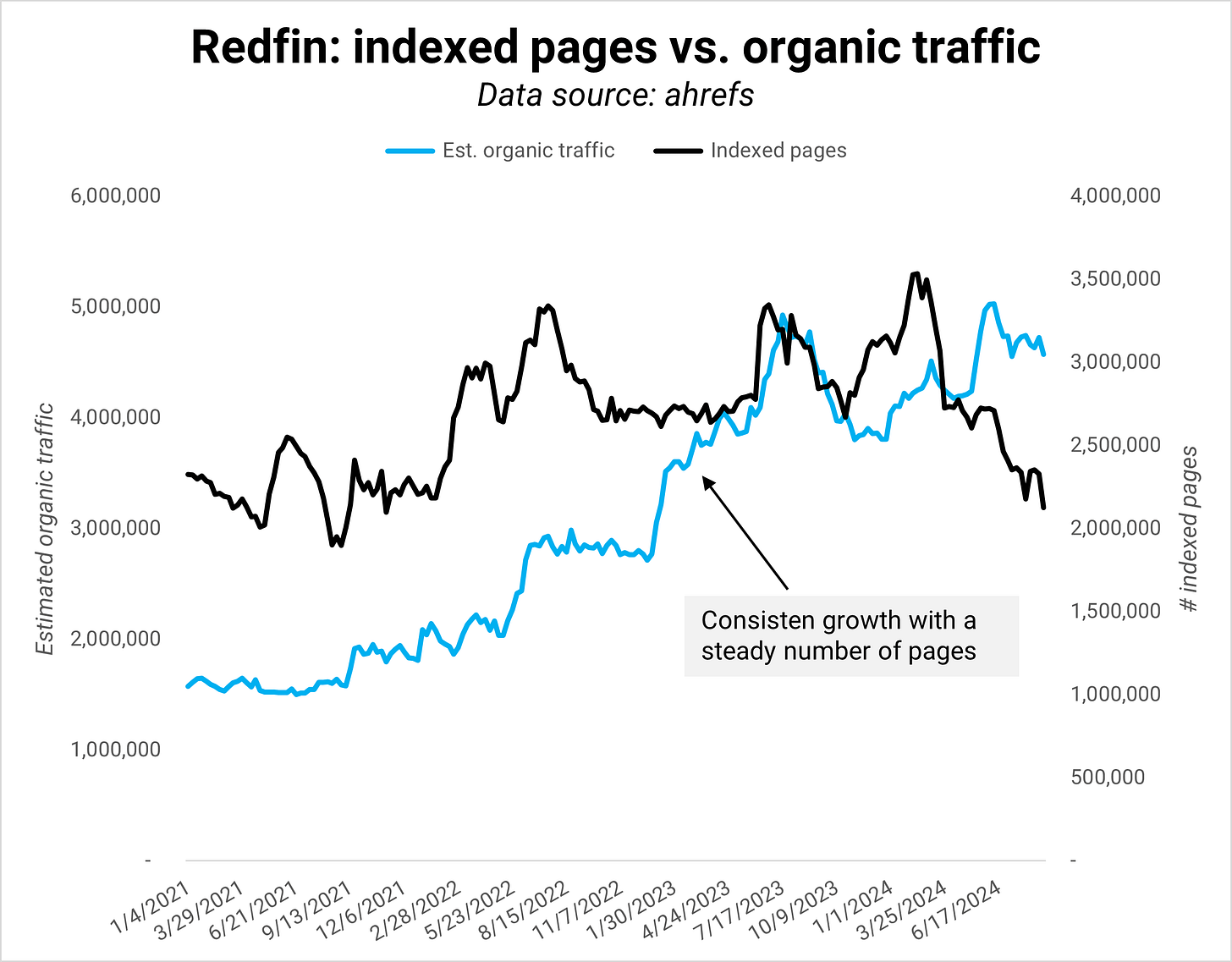

Otro ejemplo es Redfin, que mantuvo un número constante de páginas y, al mismo tiempo, aumentó significativamente el tráfico orgánico.

Citando al director sénior de Crecimiento de Productos en mi Análisis en profundidad de Redfin sobre cómo alcanzar el nivel de calidad adecuado:

Aportar nuestra experiencia local al sitio web: ser la autoridad en el mercado inmobiliario, responder a preguntas sobre cómo es vivir en una zona y ofrecer un conjunto completo de propiedades en venta y alquiler en todo Estados Unidos.

Mantener la excelencia técnica: nuestro sitio es grande (más de 100 millones de páginas), por lo que no podemos descuidar aspectos como el rendimiento, el estado del rastreo y la calidad de los datos. A veces, los esfuerzos menos «atractivos» pueden ser los más impactantes.

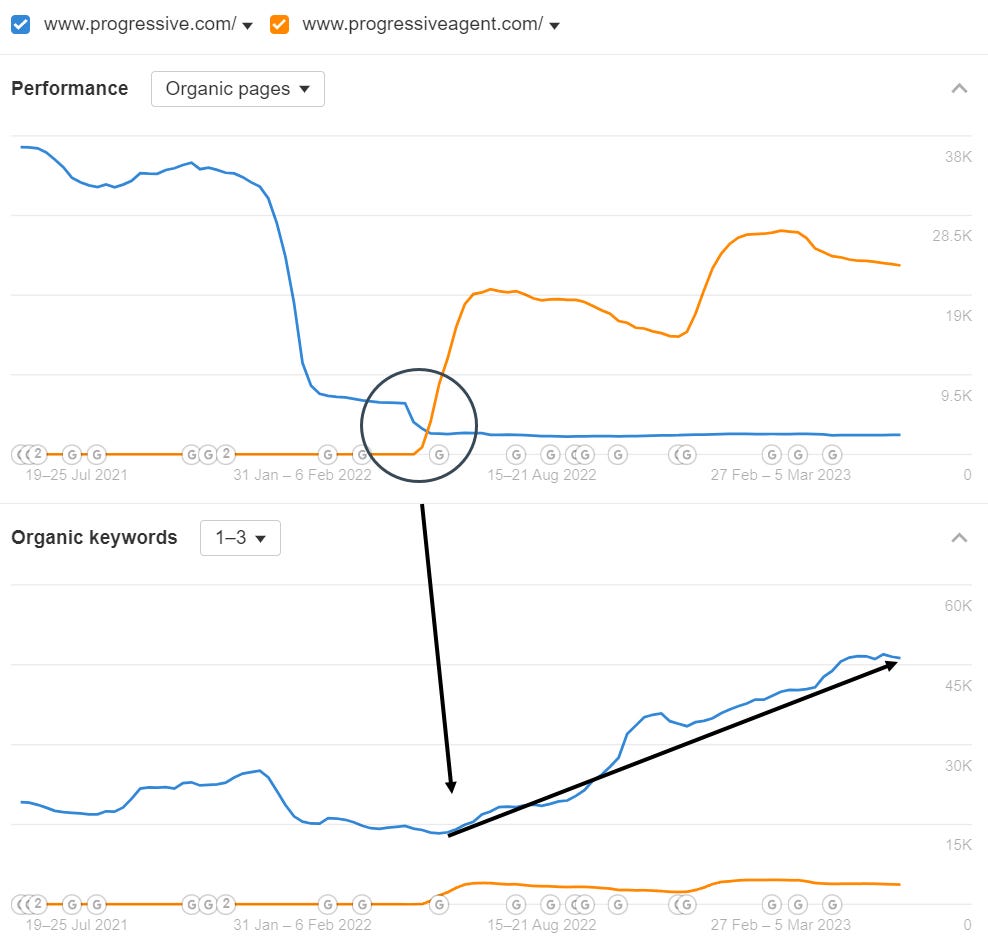

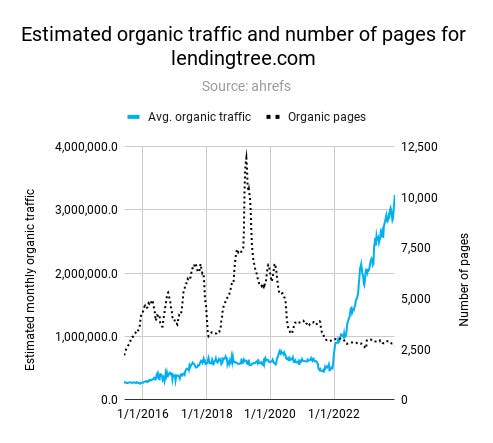

Empresas como Lending Tree o Progressive obtuvieron importantes beneficios al reducir las páginas que no cumplían sus estándares de calidad (véanse las capturas de pantalla de los análisis en profundidad más abajo).

Progressive trasladó las páginas de los agentes a un dominio independiente para aumentar la calidad de su dominio principal.

LendingTree eliminó muchas páginas de baja calidad para impulsar el crecimiento del tráfico orgánico.

Conclusión

Google premia a los sitios que se mantienen en forma. En 2020, escribí sobre cómo el índice de Google podría ser más pequeño de lo que pensamos. El tamaño del índice solía ser un objetivo al principio. Pero hoy en día, no se trata tanto de indexar tantas páginas como sea posible, sino de tener las páginas adecuadas. La definición de «bueno» ha evolucionado. Google es más selectivo a la hora de admitir a nuevos miembros en su club.

Nota: Véase también el artículo sobre SEO Profundo.

En el mismo artículo, planteé la hipótesis de que Google pasaría a una API de indexación y dejaría que los propietarios de los sitios web se encargaran de la indexación. Esto no se ha materializado, pero se podría decir que Google está utilizando más API para la indexación:

El acuerdo de 60 dólares al año entre Google y Reddit proporciona una décima parte de los resultados de búsqueda de Google (suponiendo que Reddit esté presente en los 10 primeros puestos para casi todas las palabras clave).

En el comercio electrónico, donde los listados más orgánicos aparecen en los primeros puestos de los resultados de búsqueda, Google se basa más en el feed de productos del Merchant Center para indexar nuevos productos y perfeccionar su Shopping Graph.

Las funciones de la SERP, como Top Stories, que son fundamentales en el sector de las noticias, son pequeños servicios con su propia lógica de indexación.

De cara al futuro, la gran pregunta sobre la indexación es cómo va a cambiar cuando más usuarios busquen a través de resúmenes de IA y chatbots de IA. Suponiendo que los LLM sigan necesitando poder renderizar páginas, el trabajo técnico de SEO seguirá siendo esencial; sin embargo, la motivación para indexar pasa de mostrar resultados web a entrenar modelos. Como resultado, el valor de las páginas que no ofrecen nada nuevo será aún más cercano a cero que en la actualidad.

También puede interesar:

📊 SEO + Marketing de Productos = un Plan para la Construcción de Marca

SEO + Marketing de Productos = un Plan para la Construcción de Marca o

Qué obtienen los lectores de Growth Memo:

Marcos: cómo abordar las decisiones estratégicas sobre el crecimiento orgánico, por ejemplo, cómo evaluar el verdadero potencial comercial del SEO para diferentes tipos de empresas.

Modelos mentales: patrones y principios que Kevin ha reconocido en diferentes empresas y situaciones.

Herramientas de decisión: enfoques para tomar mejores decisiones estratégicas sobre el crecimiento orgánico, como la asignación de recursos, el tiempo o la evaluación de riesgos.

Datos: estadísticas, estudios de casos y números que explican y grafican las tendencias que los responsables de la toma de decisiones necesitan conocer.

Escenarios reales: escenarios anónimos del trabajo del asesor de Kevin para destacar el proceso de pensamiento estratégico y los marcos en acción.

Una perspectiva fresca y bien documentada sobre cómo las tendencias de salud están influyendo en las estrategias de SEO. Muy recomendable para profesionales del sector.